过去大家总觉得AI卷训练,GPU训练集群动辄几个机房、几千张卡,成本动辄上亿。可到了2024年,风向突然变了。大家发现,真正决定AI模型落地效率的,其实是推理算力。

尤其是在生成式AI的大潮中,从ChatGPT到各种AI绘图、智能客服、自动生成视频……模型训练完毕后要投产、要服务用户,拼的就不再是谁的训练快,而是谁能更快更稳定地跑推理。而在这背后,有一个关键但不太被提起的角色——光模块,正变得越来越重要。

一、为什么AI推理越来越重要

简单说就是——AI走下神坛了,开始真正为业务服务了。

比如你在用一个AI客服,当你输入一句话,AI后台得马上理解你的意思,调取数据、生成回答,并在几百毫秒内把结果发回来。这个过程,背后其实就是在做推理。

而类似这种服务,每天有成千上万的请求在同时进行。模型越大,请求越多,对后端推理能力的要求就越高。根据IDC的数据,早在2022年,云端AI算力中推理占比就已经超过训练(58.5% vs 41.5%)。而到了2026年,推理占比预计将提升到62.2%。也就是说,AI正在从训练时代进入推理时代。模型不再只是造出来看看,而是要跑起来赚钱。

二、数据量暴增,带来对光模块的刚需

推理多了,自然少不了数据的高速流转。

现在的AI集群,常常由成百上千张GPU卡组成。要把这些卡“串”起来,彼此之间要进行高频、高速、低延迟的数据通信,否则模型就没法顺畅地运行。

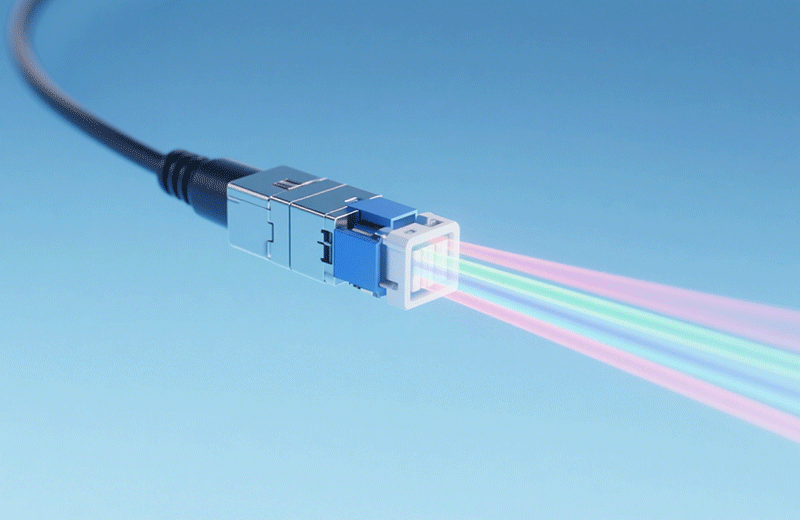

这里的“串”,说白了就是靠网络互联,而负责这些高速互联的核心器件之一,就是——光模块。

光模块的作用,可以简单理解为“在GPU、服务器、交换机之间搭起超快的信息高速路”。只有通信够快,AI算力才能真正跑得起来。尤其是当前AI主力使用的是800G甚至1.6T的高速光模块,用于高速数据中心内部互联,每一条链路的效率都可能直接影响整个平台的处理速度和稳定性。

所以别看光模块小小一个,但在AI集群这种对通信速率极度敏感的场景里,它的性能直接关系着:推理响应速度能不能实时、模型服务稳定性够不够高、数据中心整体能耗能不能控制住。

三、AI模型越卷,光模块需求越大

你可能会问,未来光模块的需求会一直涨吗

答案是:几乎板上钉钉。

因为AI行业还在快速演进,新一代模型(比如OpenAI的 o1-preview),参数量更大、调用频率更高,对带宽和连接能力的要求水涨船高。而AI厂商为了节约训练和推理的能耗成本,越来越多开始布局光电融合、高速光互联、液冷光模块等方案。光模块不再只是“配角”,而是成为支撑AI算力基础设施的一环。

未来AI算力发展到什么程度,很大一部分取决于:你能不能让海量数据高效、稳定地跑起来。AI不是单靠大模型就能跑得起来的,模型训练靠算力,模型落地靠推理,而推理离不开高速互联,而互联靠的是光模块。在这场AI变革的底层,“看不见”的光模块,正默默推动着整个行业向前。

所以,当你下一次看到一个智能客服秒回、一个AI视频几秒生成,那可能是某个光模块,在几微秒之间完成了千万次的数据传输,才让这一切变得可能。