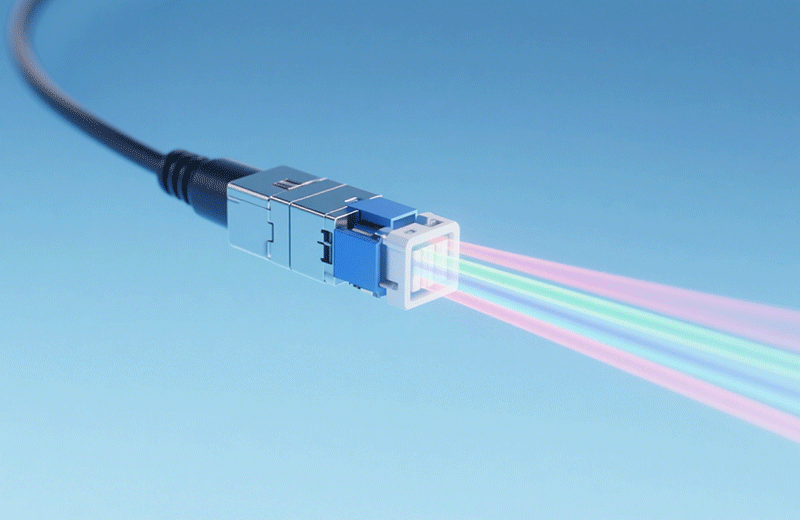

要理解光模块和算力的关系,得先想明白,算力的核心是 “处理数据”,而数据要先传得通、传得快,处理才有意义。这层关系主要体现在三个实际场景里。

第一个是带宽匹配问题,比如企业用GPU服务器训练AI模型时,单台服务器每秒能产生 20 到30GB的数据,如果配的是100G光模块,每秒最多传100GB,看起来够,但多台服务器同时工作时,数据就会堆在传输环节,GPU只能等着,算力就浪费了。换成400G或800G光模块,就能实时把数据传走,让GPU一直处于工作状态。

第二个是延迟控制,像做高频交易的企业,算力系统算完交易策略后,数据传输晚几微秒,可能就错过最佳交易时机;自动驾驶算法迭代时,延迟高了会影响模型训练效率。光模块通过优化芯片和信号处理流程,能把传输延迟压到微秒级,基本不会拖算力的后腿。

第三个是稳定性,企业的算力系统大多要24小时运行,要是光模块出问题,整个系统都得停。现在的光模块会做多通道冗余设计,比如一个800G光模块有4个通道,就算一个通道故障,其他三个还能工作。

光模块和算力的发展是同步的,甚至可以说光模块技术的升级,在推着算力系统往前走。早些年企业用单机算力时,10G、40G 光模块就够了;后来大家开始搭算力集群,几十上百台服务器一起工作,光模块就升级到 100G、200G;现在 AI 大模型需要更大规模的集群,400G光模块成了主流,头部企业已经开始用 800G 的了,明年1.6T的也会批量上市。

除了速率,光模块的功耗和体积优化也帮了算力系统不少。比如现在的800G光模块,每传1G数据的功耗比之前的400G模块低40%,一个有1000个光模块的数据中心,一年能省十几万度电,既降低成本,也减少了散热压力。体积变小后,原来一个交换机只能装24个400G光模块,现在能装48个800G的,端口密度翻了倍,企业不用扩建机房,就能容纳更多算力节点。

奥远光通的光模块在企业实际用的时候,优势很明显。首先是覆盖的速率全,从100G到 800G都有,不管企业是搭中小型数据中心,还是建大型AI算力集群,都能找到合适的型号。而且它和华为、思科、英伟达、Anist等这些主流品牌的服务器、交换机兼容性特别好,企业不用换掉现有的硬件,直接插上就能用,省了不少升级成本。

现在企业之间的算力竞争越来越激烈,选对光模块其实就是在给算力 “松绑”。选得好,算力能充分发挥,运营成本也低;选得不好,光模块就成了瓶颈,再强的算力也跑不起来。奥远光通的光模块因为适配性和稳定性都不错,不少做 AI、大数据的企业搭建算力系统时都会优先考虑。往后随着算力需求越来越高,光模块和算力的联系会更紧密,比如未来可能会把光模块和芯片直接封装在一起,进一步降低延迟。对企业来说,提前了解光模块和算力的关系,选对合适的产品,才能在数字化转型里走得更稳。