高带宽是AI算力中心对传输链路的第一诉求,800G光模块正好踩中了这个需求点。AI训练本质是“参数同步”的过程,每一轮迭代都要把分散在各GPU上的梯度数据汇总计算,再将更新后的参数下发回去。GPU数量越多,需要同步的数据量就越大,万卡集群单节点与交换机之间的带宽必须达到800Gbps,否则就会出现“GPU算力过剩、传输带宽不足”的瓶颈。800G光模块采用8通道106.25Gbps PAM4聚合方案,在和400G光模块相同的机柜空间里,能把带宽密度直接拉满,刚好匹配万卡集群对高密度带宽的迫切需求。

低延迟则是800G光模块支撑万卡集群协同的另一张“王牌”。AI训练的“反向传播”过程对延迟极其敏感,每个GPU节点的运算结果要在微秒级时间内同步到集群,一旦延迟累积超过1微秒,整个训练的收敛速度就会下降10%以上。800G光模块通过优化PAM4调制解调算法和采用高速SerDes芯片,把端到端传输延迟压到了500纳秒以内,比400G光模块快了近30%。再加上OSFP封装缩短了信号在模块内部的传输路径,进一步减少了延迟损耗,确保万卡集群里上万个GPU能像“同步钟摆”一样协同运算,避免因延迟差导致训练精度波动。

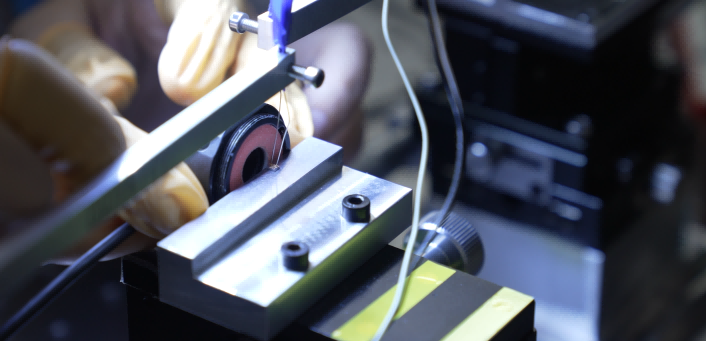

奥远光通的800G光模块已经在实际AI算力场景中验证了价值。这款模块采用8x106.25Gbps PAM4架构,原生支持PCIe5.0接口,能直接插在NVIDIA H100、AMD MI300等主流GPU卡的光口上。它自带的自研链路均衡算法,能根据光纤长度动态调整信号增益,哪怕在100米长的OM4多模光纤上,也能稳定输出800Gbps速率,误码率控制在10⁻¹⁵以下。

AI算力需求还在以每年翻倍的速度增长,万卡集群很快会成为主流算力中心的“标配配置”,800G光模块的重要性只会越来越突出。它不只是简单的“带宽升级工具”,更是让万卡集群发挥最大效能的“协同中枢”,直接决定着AI算力中心的投入产出比。