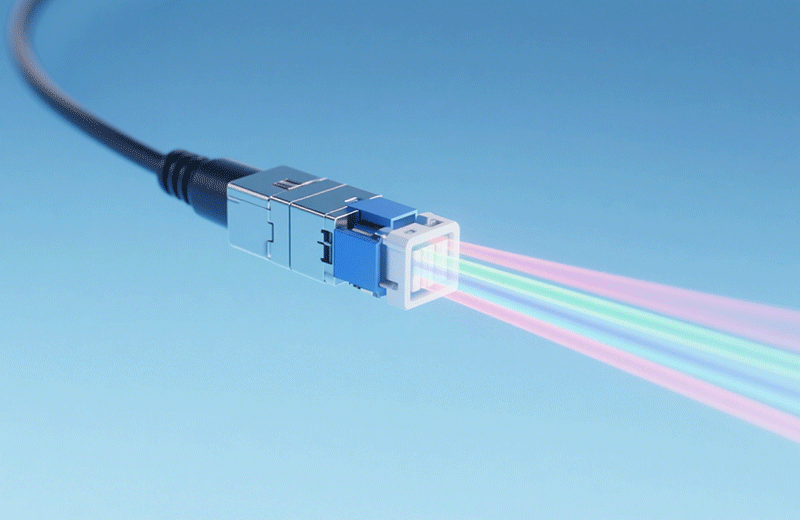

CPO共封装光学的核心就是把传统光模块和芯片之间的“物理墙”拆了,把光发射、接收组件直接塞进芯片封装里。以前传统光模块得靠高速电连接器跟芯片连,就这几厘米的电链路,信号衰减和延迟都很明显;CPO不一样,它把激光器、探测器、调制器这些光器件,跟芯片装在同一块基板上,光信号在封装内部就能完成电光转换,再通过微透镜阵列接到光纤上。这么一改,电信号传输距离从厘米级缩到毫米级,信号衰减直接降了60%多。

跟传统可插拔光模块比,CPO的优势集中在功耗、延迟、密度这三点上。功耗方面,CPO省掉了传统模块里长距离电链路的驱动功耗,1.6T的CPO模块功耗能压在12W以内,而同等速率的可插拔模块得18到20W;延迟上更明显,电信号走得近了,端到端延迟能降到150纳秒以下,正好满足AI训练时参数同步的微秒级要求;密度上,CPO封装体积只有传统模块的三分之一,同样的机柜空间,能装出两倍多的带宽。这些优势让它成了下一代数据中心核心交换机、AI芯片互联的首选,现在Intel、Broadcom这些大厂都拿出了CPO原型产品,计划2025年就能批量商用。

不过CPO技术要大规模落地,还得解决封装工艺和散热控制这两个难题。封装上,光器件和电芯片集成需要超高精度对准,微透镜阵列跟光纤的耦合精度得控制在1微米以内,这对封装设备的要求可不是一般高;散热更麻烦,CPO封装里挤了一大堆光电器件,功率密度达到50W/cm²,是传统芯片封装的3倍还多,必须用新型热界面材料加微流道冷却技术,才能把温度控制在85℃以下。现在行业里已经有解决方案了,比如陶瓷基板加金刚石散热片的复合散热方案,能把封装温度降15到20℃,算是给CPO稳定运行打了个基础。

AI算力需求涨得跟指数似的,数据中心带宽每18个月就翻一番,传统光模块的性能提升已经快碰到物理极限了,CPO共封装光学是必然要走的路。未来3到5年,CPO会从1.6T往3.2T、6.4T升级,成本也会随着量产降下来,预计2026年就能跟传统光模块持平。光模块的技术革新一直围着“更高效传输”转,而CPO通过封装集成,实现了从器件级到系统级的跨越。